1.统计学意义

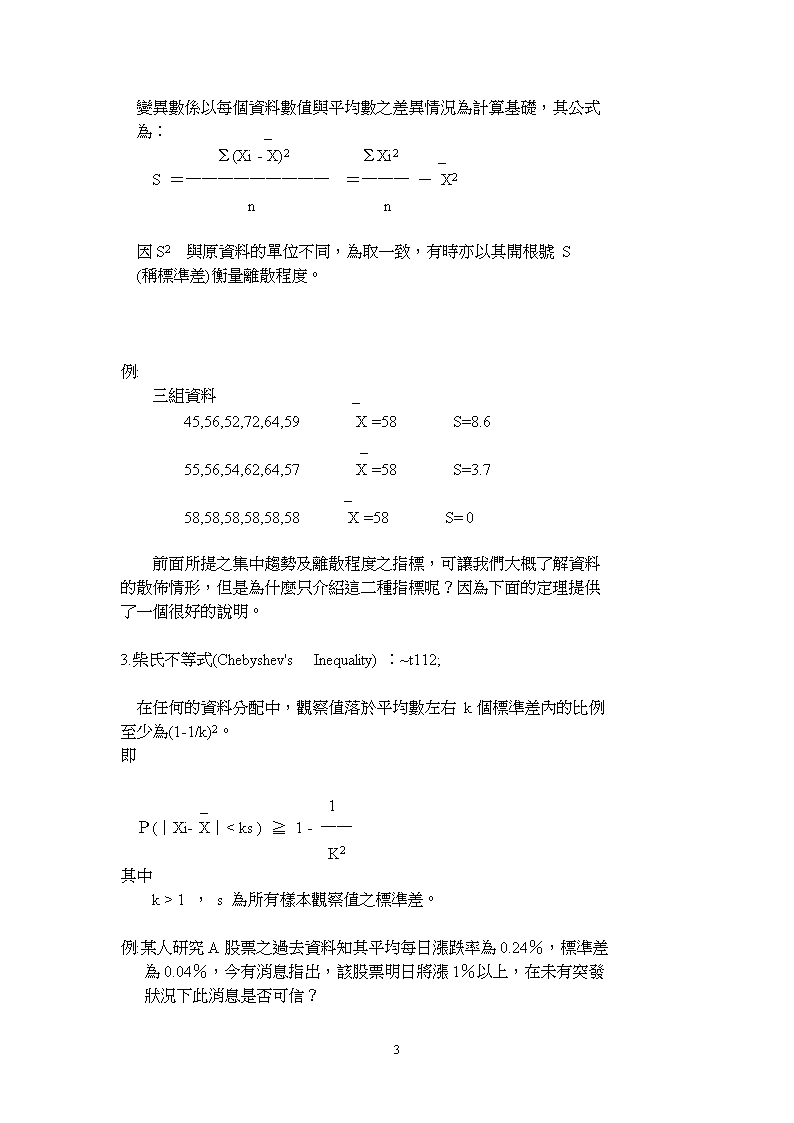

1.統計學的意義統計學是在面對不確定的情況下,提供一種可做出較為聰明、科學化決策之方法。它的過程包括對資料的蒐集、整理、陳示、解釋與分析,且大都以機率的方式來表達。┌─┐┌───┐┌─┐┌───┐│資││蒐整││陳││解分│││═>│、│═>││═>│、││料││集理││示││釋析│└─┘└───┘└─┘└───┘(重要的)(抽樣調查)(統計圖表)(敘述統計)(感興趣)(推論統計)│↓統計學重點其主要應用在於:a.使資料變得更有意義b.處理發生結果不確定性的問題c.分析各種資料間之關係d.預測2.資料基本分析法:包括集中趨勢及離散趨勢的衡量。~t52g2;集中趨勢:觀察資料較常現之位置,主要使用之測量方法有平均數、中位數、眾數。a.平均數(Mean)ˍΣXi(X1+X2+...+Xn)公式:X=────=──────────nna.中位數(Median)42\n將資料表大小排列,選擇位置居中者為平均所在。當資料個數有n個則n為奇數:中位數為第(n+1)/2個資料值。n為偶數:中位數為第n/2與第(n+2)/2個資料值之平均數。C.眾數(Mode)一組資料內出現次數最多之數值稱為眾數(一般以Mo來表示)。較常用來比較屬質的資料。離散趨勢:為何還要衡量離散趨勢?集中趨勢資訊不夠,故需再加另外的資訊判斷。例1:新進員工薪水例2:某股票的股價變化關於資料的離散程度,可使用的指標亦很多,這裡介紹二種:a.全距b.變異數a.全距(Range)全距=(MaxXi-MinXi)全距與眾數一般,均為一較粗略之指標,故在統計上較少用來衡量離散程度。b.變異數(Variance)42\n變異數係以每個資料數值與平均數之差異情況為計算基礎,其公式為:_Σ(Xi-X)2ΣXi2_S=─────────=───-X2nn因S2與原資料的單位不同,為取一致,有時亦以其開根號S(稱標準差)衡量離散程度。例:三組資料_45,56,52,72,64,59X=58S=8.6_55,56,54,62,64,57X=58S=3.7_58,58,58,58,58,58X=58S=0前面所提之集中趨勢及離散程度之指標,可讓我們大概了解資料的散佈情形,但是為什麼只介紹這二種指標呢?因為下面的定理提供了一個很好的說明。3.柴氏不等式(Chebyshev'sInequality):~t112;在任何的資料分配中,觀察值落於平均數左右k個標準差內的比例至少為(1-1/k)2。即_1P(│Xi-X│

1,s為所有樣本觀察值之標準差。例:某人研究A股票之過去資料知其平均每日漲跌率為0.24%,標準差為0.04%,今有消息指出,該股票明日將漲1%以上,在未有突發狀況下此消息是否可信?42\n例二、假設去年高考二級統計人員共有360人報考,錄取10人,已知考生平均分數為45.2分,標準差為1.4分,張三分數為54分,請問張三是否錄取?柴氏不等式最大好處是使用方便,幾乎沒有任何限制,只要有一組資料存在,均可使用,但亦因如此它所計算出之結果較粗略。而為了使資料簡化作業後之結果更精確,考慮以機率模式來簡化。參、機率~t72;由於統計主要目的在處理不確定情況,因此各種事象出現及可能發生的機會就不一樣,而為衡量其出現頻率,就須應用機率運算。一、隨機實驗若一實驗(事件發生過程)之可能發生結果事前無法預知,此種實驗就稱為隨機實驗。除了上述不可預知之特性外,通常隨機實驗還滿足下列性質:1.實驗所有結果可以描述出來(樣本空間S)。2.相同結果會重覆出現。二、機率運算機率運算主要利用集合運算性質,但主要觀念還是在古典機率上。1.古典機率古典方法主要之觀念在相對次數,即一事件A發生機率係以n(A)P(A)=──────來定義,即以事件可能發生次數占樣本空n(S)42\n間所有之可能發生次數之比例。例一、投擲一個骰子,3,6出現之機率。例二、猜物品價格遊戲有四組,假設您為第四組,前三組各猜650元、800元、及1300元,若您估算物品價格在600元至1400元請問您會猜多少元?-14-例三、一長度為L之線段,由中隨意選一點剪斷,試問長線段至少為短線段二倍長之機率為多少?設長線段長a,則短線段為L-a,由題意知:a>2(L-a)則a>2L/3,但因線段兩端均可,故2L/32機率為─────=───├──┼──┼──┤L3L例四、若台北市翡翠水庫之平均高度為200公尺,蓄水湖面呈馬蹄型試計算其可蓄水多少立方公尺?依據古典機率的觀念,對機率的計算,給予下列之設定:1.對一事件A,其發生之機率P(A)≧02.對樣本空間S,則P(S)=13.對二事件A、B,若A與B為互斥(即A∩B=φ),則P(A∪B)=P(A)+P(B)-P(A∩B)-15-針對上述之設定,可推廣出機率的一些性質:42\n1.對任二事件A、B,若AB,則P(A)≧P(B)2.由1.亦可得任一事件A,則1≧P(A)≧0例:82年三科曾請公假之人數有6人,請外勤之人數有8人,而公假、外勤皆請之人數有4人,若三科共有員工14人,則82年曾請公假或外勤之比率有多少?二、條件機率有些時候樣本空間的範圍太大,我們僅希望在一些特定的事件上觀察其他事件或者是已知某事件已經發生的情況下去了解其他事件發生的機率時,這種機率的計算,就稱為條件機率。如在已知B事件發生下,則A事件發生的機率為:P(A∩B)P(A│B)=───────P(B)>0P(B),例:三科同仁請假之情形如下:次│公事病外│數│假假假勤│────┼─────────────────┼───股 長││以 上│847213292│380││股 長││以 下│6616813848│420────┼─────────────────┼───合│150240270140│800計││42\n則1.股長以上請病假之比率有多少?132132/800 P(股長以上且請病假)────=─────=─────────────380380/800 P(請病假者)2.在請事假中,股長以下的比率有多少?一般在學統計者或以常理判斷,在已知一些資訊下,去獲取其他資訊時會有較佳之結果,但事實上並非均為如此,如果當已知B事件發生時,請問事件A發生之機率P(A)與條件機率P(A│B)何者較大?是P(A│B)≧P(A)嗎?當對條件機率稍有了解後,就可進一步去探討它在應用上的一些重要性質:1.P(A∩B)=P(A)*P(B│A)[乘法原則]例:三科欲隨機抽選一位同仁當公差,幫所有同仁提水,因此做了14個籤其中一個有記號,並由抽中此籤者為公差,請問先抽與後抽抽中之機率是否一樣?2.貝氏定理:例:人力資料調查,已知甲、乙及丙三人均審核50張調查表,依照以前審核情形,第19、20題甲判別錯誤之機率為1%,乙為2%,丙為1.5%,今有一份調查表之19、20題判別錯誤,但因編號遺漏,無法得知是甲、乙、丙何人審核,請問此調查表是由乙審核之機率有多少?公式:若B1,B2,‧‧‧,Bn滿足下列二個性質:B1∪B2∪‧‧‧∪Bn=SBi∩Bj=φ,對所有i≠j 則42\nP(A∩Bk)P(Bk│A)=────────────P(A)P(Bk)*P(A│Bk)=───────────────ΣP(Bi)*P(A│Bi)解:令事件A為調查表審核錯誤之事件,事件B1為甲審核之事件,事件B2為乙審核之事件,事件B3為丙審核之事件,則P(B1)=1/3P(A│B1)=1/100P(B2)=1/3且P(A│B2)=2/100P(B3)=1/3P(A│B3)=1.5/100依據貝氏定理知在已知調查表為審核錯誤之情形下,是由乙審核之機率為: P(A│B2)P(B2│A)=────────────────────P(A│B1)+P(A│B2)+P(A│B3)2/100=───────────────1/100+2/100+1.5/10024=───=───4.59同理42\n1/1002P(B1│A)=───────────────=───1/100+2/100+1.5/10091.5/1003P(B3│A)=───────────────=───1/100+2/100+1.5/1009若甲審核60件,乙審核40件,丙審核50件則由三人審核錯誤之機率又是多少?3.獨立事件:所謂獨立事件係指二(或多)件事件間,某事件發生之機率不受其他事件已經發生影響。即P(A│B)=P(A)且P(B│A)=P(B)則可得若P(A∩B)=P(A)*P(B)=>A與B二事件獨立。一般人通常會將二事件獨立與二事件互斥混為一談,這是錯誤的,獨立事件是一種「機率」的計算,而互斥則為「集合」的運算與機率無關。底下介紹一些有關獨立事件機率計算的例子:例一:大家樂天公牌「99」、「00」不會出;本期已出過「38」,下期再出「38」的機率較小?例二:在一次50人的聚會中,至少有二個人生日是同一天的機率有多少?人數│10│20│30│40│50│60───┼──┼──┼──┼──┼──┼──機率│0.12│0.41│0.71│0.89│0.97│0.9942\n三、機率模式機率模式主要針對下列發生狀況,以一個機率數學式子來描述:簡單或基本的現象,如投擲一個銅板、骰子等。經常出現或近似的現象,如車禍的發生頻率、考試成績分布、身高體重的分布等。由前面二類已知之機率模式,再發展出統計應用之機率模式。機率模式的好處在於以前所用來描述資料的方法仍不夠簡潔、精細,如果資料發生的情況可以用一個機率式子來表示,則對資料的分析,將會更深入更有效率。但是,這是理想的情況,現實狀況中,由於各種發生情形錯綜複雜,可以用機率模式完全表達的少之又少,故在統計學內所提及之機率模式,僅能就已發展出的加以介紹。為了使我們在研究機率模式時,能將所觀察到之現象數量化,以方便後續分析,統計學引用所謂隨機變數(RandomVariable),即給予樣本空間內之每一樣本一個且僅有一個實數。這個隨機變數以大寫之英文字母來表示,而透過隨機變數所得之值以小寫之字母表示。如投擲一個銅板,可能出現:S={ (正面),(反面)},可令隨機變數X做下列之定義:X(正面)=1,X(反面)=0┌┐┌┐│正面│X│1│S=││────────→││=R│反面││0│└┘└┘-17-並可用P(X=1)=1/2,P(X=0)= 1/242\n來表示投擲銅板所出現之情形及發生之機率,事實上可以更進一步用P(X=χ)= (0.5)x*(1-0.5)1-xχ=0,1如此對於投擲銅板或其他相同之現象就可以上述之機率模式表達。底下開始介紹一些常用之機率模式:a.均勻分布(UniformDistribution)所謂均勻分布係指樣本空間內之每一事件發生之機率都一樣。若以機率模式來表達,較常用1P(X=χ)=───,χ=1,2,3,...,NN4.統計上特殊或常用的機率分配a.均勻分配(Uniform)每種可能情況發生的機率均相同。b.伯努利分配(Bernoulli)發生情況分類成二種,"成功"及"失敗",且"成功"發生機率為pc.二項分配(Binomial)獨立地實施多次伯努利發生情況,研究重點在這多次中"成功"發生多少次。d.卜瓦松分配(Poisson)當一二項分配n很大,p很小時的情況。e.指數分配(Exponential)在一"卜瓦松發生過程"中,發生第一次所需時間。f.常態分配(Normal)資料發生的情況類似一種鐘形狀,很多自然界現象均類似此種分配。注意:1.對大部分的研究資料而言,很少恰好是上述分配的一種,但42\n可以透過一些轉換或假設得到更進一步的分析。2.隨機變數的定義與意義:其主要目的在於將研究事件數量化,以方便分析,日常生活中如身份證字號、淮考證號碼等均是。底下開始介紹一些常用之機率模式:a.均勻分布(UniformDistribution)所謂均勻分布係指樣本空間內之每一事件發生之機率都一樣。若以機率模式來表達,較常用1P(X=χ)=───,χ=1,2,3,...,NN注意:一個機率模式一定滿足下列條件:P(X=χ)≧0ΣP(X=χ)=1χ例一:投擲一個骰子。例二:由0至9中隨機抽取一數。b.伯努利分布(BernoulliDistribution)所謂伯努利分布係指隨機試驗之結果分成二個部分,一個通常稱為「成功」,發生之機率為p,另一稱為「失敗」,發生機率為1-p,若定義一隨機變數X為X(成功)=1,X(失敗)=0則我們可以P(X=χ)= px*(1-p)1-x,χ=0,142\n來表示這種發生結果僅有二種情形之事件。例:投擲一個銅板。例:投擲一個骰子,(1,3,5)為一類,(2,4,6)為一類。(1,3)為一類,(2,4,5,6)為一類。(6)為一類,(1,2,3,4,5)為一類。伯努利分布為一間斷型分布,只要隨機試驗發生之結果可以分成二類即可以此分布分析。其期望值(平均數)為成功之機率p,變異數為p*(1-p),即E(X)=pV(X)=p*(1-p)如以前例計算則例一之E(X)=p=1/2,V(X)=1/2*(1-1/2)=1/4例二可自行計算。附註:期望值具備下列三性質:1.若c為一常數,則E(c)=c。2.E(cX)=cE(X)。3.E(C1X1+C2X2+...+CnXn)=C1E(X1)+C2E(X2)+...+CnE(Xn)42\nc.二項分布(BinomialDistribution)若將一相同伯努利分布(發生「成功」之機率為p)之試驗,獨立的實施n次,若令隨機變數X為n次中「成功」之總次數,則P(X=χ)=C(n,x)px*(1-p)n-x,χ=0,1,2,...,nE(X)=n*pV(X)=n*p*(1-p)例一:高考憲法共有20問項,每個問項均為是非題,若一考生全部用猜的,則考及格(每題5分,60分及格)之機率有多少?例二:美國總統大選採選舉人票制,且若一郡為那個侯選人獲勝,則本郡選票全為一人所得,今有一郡在40年共10次選舉中,獲勝者最後都當選總統,是否可用此郡之選舉結果預測?(假設全美共有1,000郡)d.幾何分布(GeometricDistribution)若將一相同伯努利分布(發生「成功」之機率為p)之試驗,連續獨立的實施,若令隨機變數X為至第一次「成功」所需之次數,則χ-1P(X=χ)=(1-p)*p,χ=0,1,2,...其E(X)=1/pV(X)=(1-p)/p例:若已知每年索求統計要覽之單位以工商團體約占60%,其他單42\n位占40%,當今年要覽編印完成後,直至第10位才為工商團體之機率有多少?若我們將上述X之定義:第一次發生「成功」所需次數,改為第r次「成功」所需次數,則χ-1χ-rP(X=χ)=Cr-1(1-p)*p,χ=0,1,2,...E(X)=r/pV(X)=r(1-p)/p例:投擲一個骰子,六個面都出現平均需多少次?例二:若一袋中有三個白球,四個不同色色球,今以取出放回方式由袋中抽取一球觀察,請問平均需多少次四個色球都出現?上述這種分布為幾何分布之一般型,通常稱為負二項分布,除了上面例子的應用外,在抽樣上有所謂「逆抽樣法」之應用。e.卜瓦松分布(PoissionDistribution)卜瓦松分布運用的情形很多,如十字路口的車禍發生事件、商店或超市收銀口顧客進出人數...等,另外當二項分布之n很大而n*p為一常數(假設為u)時,其分布亦會接近卜瓦松分布。若令隨機變數X為一定長時間(區間)之事件發生次數,而u為此一定長時間之平均發生之數,則X之機率分布為:-uχe*uP(X=χ)=────────,χ=0,1,2,...χ!其中42\ne=2.718281χ!=χ(χ-1)(χ-2)...2*1如6!=6*5*4*3*2*1=720E(X)=uV(X)=u例:已知本科每日上班在7:50至8:20之間到辦公室之人數為一卜瓦松分布且依以前資料知此段時間內到達之同仁平均有5人,問有一上班天都沒有一人於此段時間到達之機率?例:前面二項分布所提美國總統大選採選舉人票制,且若一郡為那個侯選人獲勝,則本郡選票全為一人所得,今有一郡在40年共10次選舉中,獲勝者最後都當選總統,假設每一郡均為隨機投票下,至少有一郡產生上述結果之機率。f.超幾何分布(HypergeometricDistribution)超幾何分布與前所提伯努利、二項、幾何...等分布最大之不同處在於超幾何分布是由不放回抽樣(非投返法)所得,假設一袋中有白球N1個,黑球N2個,N1+N2=N,若由袋中以不放回方式抽出n個球,令隨機變數X為n球中白球之個數,則N1N2Cχ*Cn-χP(X=χ)=────────,χ=0,1,2,...,n N CnN1E(X)=N*──=NPN42\nN-nV(X)=─────*NP(1-P)N-1由於超幾何分布係由不放回方式而得,此與抽樣調查之方式一致,故此分配在抽樣方法中會有更詳盡的介紹,一般超幾何分布之應用例子在計算生物個數。例:翡翠水庫內共有多少魚。計算方式:1.首先在水庫中補魚,假設補到N1條魚,作上記號,再放回水庫中。2.待魚均勻散佈在湖中後,再次補魚,假設補到n條魚,其中有記號的魚有χ條。3.若水庫中有N條魚,則可以N1χ───=───=>N=N1*n*χNng.指數分布(ExponentialDistribution)指數分布乃緣於卜瓦松分布,在卜瓦松分布中我們考慮於一卜瓦松過程下,欲研究的為在單位時間或區間內事件發生之次數,現將研究的對象改為發生第一次事件所需要之時間,若定義隨機變數X為在卜瓦松過程下,發生第一次事件所需時間(或區間),則-uχf(χ)=ueχ>0,其中u為卜瓦松過程下,單位時間內平均發生次數。證明:42\n├──┼───────┤令Y為(0,χ)時間內0χχ發生事件次數,則Y為卜瓦松分布,平均發生次數為uχ,且P(X≦χ)=1-P(X≧χ)=1-P(Y=0)-uχ0e*(uχ)=1-────────0!-uχ=1-ed=>f(χ)=──P(X≦χ)dχ-uχ=ueχ>0 ,又因X為連續性之隨機變數,而u為間斷型之發生次數,故將u以1/θ代替,此時1-(1/θ)χf(χ)=──eθ,χ>0θ為每發生一次平均所需時間。E(X)=θV(X)=θ42\n例一:某機器之壽命為服從指數分布,且平均壽命為5年,試問此機器在2年之內即故障之機率?例二:在公車站等待公車之過程服從卜瓦松過程,假設每6分鐘一班公車,請問到站後等待超過10分鐘之機率?h.常態分布(NormalDistribution)常態分布又稱為鐘型分布或高斯分布,在日常生活中的一些現象均與此分布極類似,故在統計學中為最重要之分布。其機率分布為χ-μ2│1-(1/2)(─────)│f(χ)=───eσ│2πσ,│─────┴──────-∞<χ<∞,-∞<μ<∞,σ>0E(X)=μV(X)=σ2例:若某次考試成績為服從平均數μ=72,標準差σ=4之常態分布,請問成績及格之比例?P(X≧60)=由上例知,若μ,σ改變,則每次均需重覆利用積分計算發生之機率,為改善這種情況,利用下述標準化之定理,則可省掉很多計算過程。定理:若X~N(μ,σ2 ),令新變數42\nX-μZ=──────,則Z~N(0,1),稱為標準常態分布σ有了上述定理後,任何之常態分布機率均可利用標準常態表查表得到。例:X~N(72,16),則X-7260-72P(X≧60)=P(─────≧─────)44=P(Z≧-3 )=1若X~N(2,1),則X-20-2P(X≧0)=P(─────≧─────)11=P(Z≧-2 )=由上面例子可以知在常態分布中標準化定理可簡化很多機率計算問題。事實上任何常態分布之線性組合仍為常態分布:例:若X具有N(c1,d1)Y具有N(c2,d2)則aX+bY~N(c1+c2,d1+d2+2cov(X,Y))42\n肆、估計前面所討論的主要在於如何去了解一個母體,或去敘述各個現象可能發生的機率...等,為敘述統計的部分,至於估計或檢定則是在一有效的抽樣結果下(通常是隨機抽樣)且在已知母體是何種分配,但重要參數(parameters)無法確定情況下,如何去分析、推論這些參數,我們要介紹的是估計與檢定。前提:手中已握有一組來自具有機率分配f(χ;θ)母體之隨機樣本X1,X2,...,Xn,並且利用這組(X1,X2,...,Xn)去估計、檢定未知之參數θ。一、如何估計未知參數的方法統計學內估計的方法主要有三種:1.最大概似估計法(MethodofMaximunLikelihood)2.最小平方法(MethodofMinimunLeastSquare)3.動差法(MethodofMonments)其中最經常用到的為最大概似估計法,而最小平方法在迴歸分析中有詳盡的介紹,至於動差法一般則是前述二法無法估算時,方派上用場。最大概似估計法例一:若一箱中有白、紅球各若干,已知共有12顆球,今由箱中以取出放回方或抽取四球觀察,結果有三紅球、一白球,請估計箱中紅、白球各有多少個?Ans:9個(為什麼?)42\n例二:若欲知道支持台北市市長侯選人陳水扁之計程車有多少輛,假設是由1號開始編號,今在街上隨機取得5輛支持計程車,且號碼分別為124,652,65,372,266請問支持之計程車共有幾輛?Ans:652輛(why?)由例一例二可知,最大概似估計法所要表達的觀念在於對所有可能發生的參數值(即所謂參數空間),找到一個值使得「當未知參數真的為此值時,觀察到這組已在手中之隨機樣本之機率最大。」通常,觀察到這組資料或隨機樣本之機率會與未知之參數有關,並且為P(X1=χ1,X2=χ2,...Xn=χn)=P(X1=χ1)*P(X2=χ2)...P(Xn=χn)=L(θ)︿L(θ)特稱為概似函數。而最大概似法即在於找到一θ使得︿L(θ)= MaxL(θ)前面所提之二個例子,一為二項分配,一為間斷型均勻分配:解:一、P(X1=χ1,X2=χ2,...Xn=χ4)= P*(1-P)(P為紅球出現機率)=P-P242\n則欲MaxL(P)dL(P)───────=P*(3-4P)=0dP則P=0(不合)或P=3/4P=3/4為紅球出現機率,即箱中有9個紅球時使得觀察到3紅1白之機率最大。二、假設共有N部計程車1 dL(N)1L(N)=(───)=>──────=-5(──)Nd NN以微積分方法無法解得最大值,另分析:欲MaxL(N)即MinN1因f(χ)=──,χ=1,2,...,NN故任何χ均須小於N,即Maxχ≦N所以N最少為 Maxχ,以5個資料而言,估計N=652其他特殊分配參數之最大概似估計式亦可以上述觀念求出。42\n動差法**動差法主要在於假設n個資料每個出現之機率均相等且為P(X=χi)=──,χ=1,2,...,nn則 Σχi各階動差E(X )=──────n故以χ──>E(X)Σχi────────>E(X)n假設我們已經知道如何應用統計上所提到之估計方法找到估計值,但由於估計方法的不同,將產生如何判斷那一個估計值較好的問題,為解決此新的難題,在統計上,我們認為一個好的估計值應具有一些優良的性質,一般來說有:1.充分性(Sufficience)2.不偏性(Unbiase)3.有效性(Efficience)4.一致性(Consistence)底下分對這幾個性質加以說明:1.充分性(Sufficience):42\n所謂充分性乃在於當估計一未知參數θ時,由原隨機樣本所構︿_成之估計式θ(例X,S,MaxX,...)其獲取有關θ之資訊,若與原隨機樣本(X1=χ1,X2=χ2,...Xn=χn)沒有差異時,就︿稱θ對欲估計之參數θ具有充分性。例:市長選舉,設投票選黃市長為1,其他為0,則對於黃市長是否當選這個參數,如ˍΣXi,X均為具有充分性之估計式ˍ因為ΣXi,X所能知道黃市長是否當選的資訊與(X1=1,X2=0,ˍ..Xn=1)完全一樣,故ΣXi,X均具有充分性,事實上(X1=χ1,X2=χ2,...Xn=χn)亦具有充分性,惟因其所需了解之事項較多(n項),較少使用。綜合以上,可知充分性乃是一個估計式(值)最少應具備之性質,因為若缺少了充分性,則原本可知道有關未知參數之資訊(由X1,X2,...,Xn得知)即浪費了,因此在應該知道的資訊絕不輕易放棄下,充分性就格外顯得重要了。至於在數理上,統計學給予充分性如下之定義:定義:若已知(X1=χ1,X2=χ2,...Xn=χn)為一組來自具有機率分配f(χ;θ)母體之隨機樣本,其中θ為待估計之參數,假︿設θ為(X1=χ1,X2=χ2,...Xn=χn)所構成函數以估計θ,︿若滿足在給定θ之條件下,(X1=χ1,X2=χ2,...Xn=χn)之42\n條件機率分配︿︿f(χ;θ│θ)=P(X1=χ1,X2=χ2,...Xn=χn│θ) ︿P(X1=χ1,X2=χ2,...Xn=χn,θ)=───────────────────︿P(θ)︿與θ無關,則θ即為一具有充分性之估計式(值)。例:若(X1=χ1,X2=χ2,...Xn=χn)為一組來自伯努利分配,成功機率為P之隨機樣本,試證明ΣXi為P之一充分性之估計式。證明: P(A∩B)︿因P(A│B)=───────,θ=ΣXiP(B)故P(X1=χ1,X2=χ2,...Xn=χn│ΣXi=y)P(X1=χ1,X2=χ2,...Xn=χn,ΣXi=y)=────────────────────────── P(ΣXi=y)P(X1=χ1,X2=χ2,...Xn=χn,ΣXi=y)────────────────────────,Σχi=yP(ΣXi=y)=0Σχi=y當Σχi=y42\nP(X1=χ1,X2=χ2,...Xn=χn,ΣXi=y)────────────────────────P(ΣXi=y) P(X1=χ1,X2=χ2,...Xn=χn)=─────────────────────yn-yC(n,x)P*(1-P)χ11-χ1χ21-χ2χn1-χnP*(1-P)*P*(1-P)*...P*(1-P)=────────────────────────────yn-yC(n,x)P*(1-P)-39-Σχin-ΣχiP*(1-P)=───────────────────────yn-yC(n,x)P*(1-P)1=──────與未知參數P無關,故ΣXi為一具充分性之C(n,x)估計式。附註:上面的作法,第一的反應就是要判別一個估計式是否具充分性都需如此繁複的計算嗎?答案當然不是!事實上要判別是 否具充分性有其他定理可用:分解定理:42\n對未知參數θ,若一隨機樣本之發生機率滿足P(X1=χ1,X2=χ2,...Xn=χn)=G(T(χ1,χ2,...,χn);θ)*H(χ1,χ2,...,χn)其中G為一估計式T(χ1,χ2,...,χn)與θ構成之函數,H則為與θ無關由χ1,χ2,...,χn構成之函數。則對估計θ而言,T(χ1,χ2,...,χn)具充分性。-40-~[r400]~[c1]~[?93]~ij6j3jkt96fd8q15x0l6h;~t72;例如上述伯努利分配例子,由定義已證明ΣXi具充分性,依分解定理P(X1=χ1,X2=χ2,...Xn=χn;P)Σχin-Σχi=P*(1-P)可令G(T(χ1,χ2,...,χn);P)Σχin-Σχi=P*(1-P),T=ΣχiH(χ1,χ2,...,χn)=1故T=Σχi具充分性。-41-2.不偏性(Unbiase)42\n所謂不偏性係指就長期而言,若一估計式(值)之平均數正好等於欲估計之參數,則稱此估計式具有不偏性,即︿若θ為θ之一估計式,若︿E(θ)=θ,則θ就具有不偏性。例:以前面伯努利分配而言,因ˍΣXi1E(X)=E(────)=──(E(X1)+...+E(Xn))nn1=──(P+P+...+P)=Pnˍ故X具不偏性。另E(X1)=P(第一個觀察值亦來自伯努利分配,故期望值為P)1E(──(X1+X2))=P2 ˍ所以X1及1/2(X1+X2)均具不偏性。但已知X具充分性,而X1及1/2(X1+X2)並未具充分性,可知單由不偏性無法很有效看出估計式的好壞,底下例子更說明了這個現象:︿︿︿︿例:θ1,θ2均用來估計θ,由右│θ1-θ│θ2-θ︿────┼────┼────表知θ1與θ之誤差僅為1或P=1/2│1│100︿︿││42\n-1,而θ2為100及-100,θ1P=1/2│-1│-100︿││明顯優於θ2,但︿︿E(θ1-θ)=1/2*1+1/2*(-1)=0=E(θ1)-θ︿︿E(θ2-θ)=1/2*100+1/2*(-100)=0=E(θ2)-θ︿︿即θ1,θ2均具有不偏性,故由不偏性反而無法判別優劣,為改善上面出現之缺點,再多加考慮另一性質,即有效性。3.有效性(Efficience)由不偏性所產生之缺點在於無法判別資料之離散程度,因此除︿了不偏性外,應再考慮估計式之變異數,以上面例子觀察,θ1及︿︿︿θ2均具不偏性,但若計算E(θ1-θ)及E(θ2-θ)則可避︿︿免正負抵消的問題,而E(θ1-θ)=V(θ1)=1*(1/2)+1*(1/2)=1︿E(θ2-θ)=10000*(1/2)+10000*(1/2)=10000馬上可比較出︿︿θ1及θ2之好壞,故一不偏估計式的變異數越小則越好,並給予下列定義:一不偏估計式具有效性,則此估計式之變異數是所有不偏估計中最小者。由於不偏估計式有太多個,找出一個具有最小變異數之不偏估計並不容易,實務上我們通常比較相對有效性:︿︿︿︿︿若θ1及θ2均具不偏性,且V(θ1)<V(θ2),則θ1稱具相對有效性。︿有時候,我們會踫到兩難的情況,即θ1為不偏但變異數較大︿而θ2非不偏但變異數較小,此時改採均方誤(MeanSquareError)42\n比較二估計式的好壞。︿︿︿θ1之均方誤為MSE(θ1)=E(θ1-θ)2︿︿︿θ2之均方誤為MSE(θ2)=E(θ2-θ)2均方誤在於計算估計式與未知參數長期二者誤差平方的平均數為多少,因此對一估計式來說,其均方誤越小越好。而欲計算出均方誤只需依照期望值的定義計算即可,或依底下分解亦可簡化計算過程:︿︿MSE(θ1)=E(θ1-θ)2︿︿︿=E(θ1-E(θ1)2+E(θ1)-θ)2︿︿︿=E(θ1-E(θ1))2+(E(θ1)-θ)2︿︿︿+2E(θ1-E(θ1))*(E(θ1)-θ)=V(θ1)+(E(θ1)-θ)2=θ1之變異數+(偏 誤 )24.一致性(Consistence)所謂一致性乃在於當樣本個數n趨近於極大時(類似普查),若估計式(值)之結果與未知參數一樣或誤差在一可容許的範圍內,就稱此估計式具有一致性。依上面說明,一致性大致可分為在抽樣上及統計機率上之定義:42\n(1)抽樣上:︿︿︿若一估計式θ在n─>N時,θ=θ,則θ稱具有一致性。ˍ1例:母體的未知參數為X=──ΣXi,則N估計式a.X1b.1/2(X1+X2)c.Med(X1,X2,...,Xn)_1d.X=──ΣXin_1僅有d.X=──ΣXi為具有一致性,因當n─>N時n_ˍX=X。-45-~[r400]~[c1]~[?93]~ij6j3jkt96fd8q15x0l6h;~t72;(2)統計機率上:︿若一估計式θ在n─>∞時,滿足︿P(│θ-θ│<ε)=1,對任一極小正數ε而言。︿︿則θ就稱具有一致性。亦即在n─>∞時,θ-θ之值在-ε及+ε之間的機率為1。42\n在誤差範圍內有│..│.│↙無窮多個。在誤差範圍│..│...│外僅有有限↘.│...│..│.個。.│...│.│.│..│..│︿───┴──┼──┴────θ-θ-ε│0+ε若一估計式滿足上述性質,就可稱具有一致性(在統計機率上)。區間估計(ConfidenceInterval)前面所敘述之估計方法一般稱為點估計方法,即對於未知之參數以一個數值來估計,其令人懷疑之處在於可信度有多高,與未知參數之差距有多大,縱使在我們已知具有一些好的性質下。針對以上的不足,故有區間估計(或信賴區間)的產生,所謂區間估計乃尋找一個區間使得這個區間包含未知參數之機率有一信賴度1-α,並稱此一區間為未知參數之(1-α)100%信賴區間。找尋信賴區間的方法主要按照下列步驟:︿1.找一個具有充分性之估計式θ。︿︿2.找到一個由θ與未知參數θ合成之函數G(θ,θ),並且此函數之分配必須已知或可以求得。︿3.利用G(θ,θ)求得未知參數θ之信賴區間。例:若隨機樣本X1,X2,...,Xn為來自N(μ,1),試求μ之95%信賴區間。42\nˍ解:已知X為μ之充分性估計式,且ˍ1X~N(μ,──)n則我們希望找到一L及U使得P(L<μ∞時,__X-μΣXi-nμW=──────=────────~N(0,1)σ/nnσ例:前面二項分布所提美國總統大選採選舉人票制,且若一郡為那個侯選人獲勝,則本郡選票全為一人所得,今有一郡在40年共10次選舉中,獲勝者最後都當選總統,假設每一郡均為隨機投票下,至少有一郡產生上述結果之機率。例:台灣電力公司因油價下跌,每月可節省發電成本200萬元,為回饋用戶,擬將現有82萬用戶電費不足一元部分全部不收費,請問這項政策在不超過200萬元的前提下是否可行?伍、檢定(TestingHypothesis)檢定亦為統計推論的一部分,乃先假設母體的未知參數屬於某一種情況(此假設即稱虛無假設以Ho表示),與此假設對立之情況則另一假設稱對立假設(一般以Ha或H1表示)。檢定的做法即在於42\n根據隨機樣本(X1,X2,...,Xn)如何接受虛無假設(亦可說拒絕對立假設)或拒絕虛無假設(接受對立假設)。首先需說明的是到底虛無假設與對立假設應該如何設立,兩個互相對調可以嗎?由於至目前為止,整個檢定推論的理念仍基於黎曼─皮爾生的構思與理論,因此假設之設立乃依其理論以「欲拒絕的事象」設為虛無假設,實務上我們可以將虛無假設與對立假設互調,若二種檢定結果不矛盾,則依檢定結果,若矛盾,則係樣本之個數不夠多,無法顯示虛無假設與對立假設之差別,故可以增加樣本數重新檢定處理。另外需說明的是,在統計學裡,"="是設在虛無假設內,原因說明如下。由於在檢定是否拒絕虛無假設時,可能發生的錯誤為下列情況:1.當虛無假設為正確時,卻拒絕虛無假設。2.當虛無假設為錯誤時,卻接受虛無假設。第一種誤差我們稱型Ⅰ誤差(TypeⅠerror)第二種誤差則稱為型Ⅱ誤差(TypeⅡerror)而型Ⅰ誤差發生的機率特別稱為α,型Ⅱ誤差發生的機率則稱β,整個統計檢定作業即在於考量如何讓α及β較小情況下,決定是否接受或拒絕虛無假設。不過天下事很難可以兩全其美,因為α與β存在42\n底下關係:(1)若欲α下降,則β就上升(註:α+β≠1)(2)若欲β下降,則α就上升(3)若欲α及β均下降,則需提高樣本數(增加成本)此時我們可考慮採行之決策方式:(1)找到一個檢定方式其α及β均最小。(2)找到一個檢定方式其α+β為最小。(3)在所有第一型誤差發生機率固定為α之檢定中,找出其中β最小之檢定。(4)在所有第二型誤差發生機率固定為β之檢定中,找出其中α最小之檢定。上述四種決策方式均甚合理,惟由α與β關係,在不增加預算下,(1)及(2)均無法達成,而黎曼-皮爾生二位學者則證明在(3)下可以找到一個標準作業方式,以尋找出較佳之檢定方式。即可以在所有固定α之檢定中找到一個β最小之檢定。但這並不表示(4)就沒有用處,有些研究即在探討有那些集群可以滿足固定β下,α最小之檢定。也就因為至目前為止,黎曼-皮爾生的檢定作業方式或邏輯概念乃是整個檢定的主軸,故在虛無假設的設定上,亦受了固定α求42\nβ越小的限制(欲拒絕的事象設為虛無假設),且因固定α,則"="就一定需設在虛無假設內,甚至於以區間估計方式求解檢定問題時同樣的觀念亦會影響分析的結果。黎曼-皮爾生定理(Lemmen-PearsonLemma)對於一虛無假設Ho:θ=θo;對立假設Ha:θ=θa,若隨機樣本(X1,X2,...,Xn)來自f(χ;θ),且若樣本空間之一部分集合C,用以拒絕Ho,滿足:L(χ1,χ2,...,χn;θo)1.────────────≦k,當(χ1,χ2,...,χn)εCL(χ1,χ2,...,χn;θa)2.P((χ1,χ2,...,χn)εC│θ=θo)=α則對另一檢定當(χ1,χ2,...,χn)εD拒絕Ho,且滿足P((χ1,χ2,...,χn)εD│θ=θo)=α而言,β=P((χ1,χ2,...,χn)εC│θ=θa)≦P((χ1,χ2,...,χn)εD│θ=θa)即以(χ1,χ2,...,χn)εC拒絕Ho之檢定對其他第一型誤差發生機率亦有α之檢定而言,其具有最小之第二型誤差發生機率。42\n例:一袋中共有10個球,紅、白、黑球分配如下:││││θ1│θ2│θ3───┼───┼───┼────紅│6│1│1│││白│2│5│1│││黑│2│4│8│││───┴───┴───┴────今由袋中抽出一球觀察,試檢定下列假設:(1)Ho:θ=θ1在α=2/10時Ha:θ=θ2(2)Ho:θ=θ1在α=2/10時Ha:θ=θ2或θ=θ3上述問題是對於釐清檢定觀念很好的例子,事實上整個檢定主要概念建立在最大概似(概度比檢定亦同),即比較在已觀察資料下,來自虛無假設與對立假設的機率孰高,較高者就認定其較有可能來自那個假設狀況。42\n陸、無母數統計(NonparameterStatistics)1.卡方檢定2.Sign檢定3.Sign-Rank檢定4.Run檢定5.K-w檢定6.其他無母數方法柒、貝氏估計(Baysian'sEstimation)貝氏估計與傳統古典估計方法最主要的差異,在於古典統計估計中,母體未知參數係為一"定數",並藉由一系列方法測知此定數的相關訊息。而貝氏估計為因應現實中,母體未知參數會隨時空改變,並非一固定不變之常數,若假設母體未知參數本身會服從某種分配下,此時可利用貝氏估計方法來估計未知之參數。假設X1,X2,...,Xn係來自具有機率分配為f(χ;θ)母體之隨機樣本,且θ~g(θ;μ),此時利用條件機率的一些性質可得到下列結果:已知:42\nf(χ,θ)=f(χ;θ)*g(θ;μ)=f(χ︳θ)*g(θ;μ)則h(θ︳χ)=f(χ,θ)/t(χ)假設我們希望估計之條件變異數最小,則最佳之估計為事後分配之條件期望值。有些時候亦有要求最大損益極小化(Minimax)性質,惟其估計較難計算,請參考其他決策理論或數理統計書籍。例:若X1,X2,...,Xn係來自poisson(λ)之隨機樣本,且已知λ~U(0,1)則在條件變異數最小下,λ之最佳估計式為何?42\n42